人工智能推动创新者建造全新的半导体

半导体是数字时代的基础技术。它给硅谷起了个名字。它位于计算革命的核心,在过去的半个世纪里,这场革命改变了社会的方方面面。

自从英特尔在1971年推出世界上第一个微处理器以来,计算能力的提高速度一直令人叹为观止,而且坚持不懈。根据摩尔定律,今天的计算机芯片比五十年前强大数百万倍。

然而,虽然处理能力在过去几十年里飞速增长,但计算机芯片的基本架构直到最近才基本保持不变。在很大程度上,硅的创新需要进一步小型化晶体管,以便将更多的晶体管挤到集成电路上。像英特尔和AMD这样的公司几十年来一直通过可靠地提高CPU能力而蓬勃发展,这一过程被克莱顿·克里斯滕森称为“持续创新”。

今天,这种情况正在以戏剧性的方式发生变化。AI开启了半导体创新的新黄金时代。机器学习的独特需求和无限机会,几十年来第一次促使企业家们重新审视和重新思考甚至是芯片架构的最基本原则。

他们的目标是设计一种专为人工智能打造的新型芯片,为下一代计算提供动力。它是当今所有硬件中最大的市场机会之一。

在计算史上的大部分时间里,主流的芯片架构一直是CPU,即中央处理单元(Central Processing Unit)。如今,CPU无处不在:它们为您的笔记本电脑、移动设备和大多数数据中心提供动力。

CPU的基本架构是由传奇人物约翰·冯·诺伊曼于1945年构思出来的。值得注意的是,从那时起,它的设计基本上没有改变:今天生产的大多数计算机仍然是冯·诺伊曼(Von Neumann)机器。

CPU在各种用例中的优势是其灵活性的结果:CPU是通用机器,能够有效地执行软件所需的任何计算。但是,虽然CPU的主要优势是多功能性,但今天领先的人工智能技术需要非常具体和密集的一组计算。

深度学习需要迭代执行数百万或数十亿个相对简单的乘法和加法步骤。以线性代数为基础的深度学习基本上是基于试错的:随着模型的逐渐优化,参数被调整,矩阵被相乘,数字在神经网络中一遍又一遍地求和。

这种重复的、计算密集的工作流对硬件体系结构有一些重要的影响。并行化-处理器同时执行多个计算的能力,而不是逐个执行的能力-变得至关重要。与此相关的是,因为深度学习涉及到海量数据的持续转换,所以将芯片的内存和计算核心尽可能地放在一起可以通过减少数据移动来大幅提高速度和效率。

CPU装备不足,无法支持机器学习的独特需求。CPU按顺序处理计算,而不是并行处理。它们的计算核心和存储器通常位于单独的模块上,并通过有限带宽的通信系统(总线)连接。这在数据移动中产生了一个被称为“冯·诺伊曼瓶颈”的瓶颈。结果是:在CPU上训练神经网络的效率低得令人望而却步。

考虑到机器学习应用在整个社会变得如此普遍,传统芯片无法处理现代人工智能算法的能力变得更加重要。正如人工智能伟人严乐村(Yann LeCun)最近所说:“如果你进入未来五年、十年,看看计算机在做什么,我认为它们大部分时间都在做深度学习之类的事情。”

在这一点上,推动人工智能热潮的芯片是GPU(图形处理器)。GPU架构是NVIDIA在20世纪90年代末为游戏应用程序发明的。为了以高帧率渲染计算机游戏的详细图形,GPU是专门为连续处理大量数据而构建的。与CPU不同,GPU可以并行完成数千次计算。

在2010年代初,人工智能社区开始意识到,NVIDIA的游戏芯片实际上非常适合处理机器学习算法所需的工作负载类型。由于运气非常好,GPU发现了一个巨大的新市场。NVIDIA利用了这个机会,将自己定位为市场领先的人工智能硬件供应商。结果,该公司获得了令人难以置信的收益:从2013年到2018年,NVIDIA的市值增长了20倍。

然而,正如Gartner分析师Mark Hung所说,“每个人都同意GPU没有针对人工智能工作负载进行优化。”GPU已经被AI社区采用,但它并不是为AI而生的。

近年来,一批新的企业家和技术专家开始重新想象计算机芯片,从头开始对其进行优化,以释放人工智能的无限潜力。用艾伦·凯(Alan Kay)令人难忘的话说:“真正重视软件的人应该自己制造硬件。”

在过去的24个月里,已经出现了5家AI芯片独角兽公司。又有几家初创公司以令人瞠目结舌的估值被抢购一空。作为寻求避免中断的传统CPU现任公司,仅英特尔一家就在这一类别进行了两次重大收购:Nervana Systems(2016年4月以4.08亿美元收购)和哈瓦那实验室(2019年12月以20亿美元收购)。随着这场竞赛在未来几年展开,数千亿美元的企业价值将可供争夺。

巨大的市场机会和蓝天技术挑战的结合,激发了寒武纪设计理想人工智能芯片的创造性-有时令人震惊-的方法的爆发。

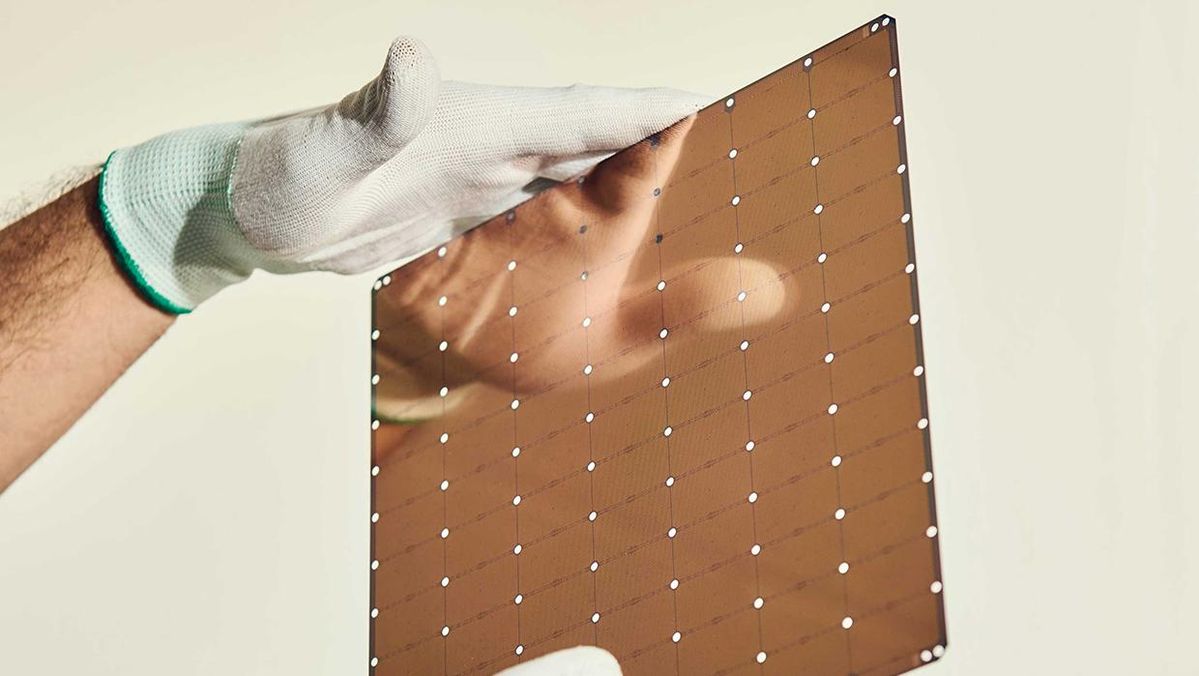

也许在新一批人工智能芯片初创公司中,最引人注目的是大脑系统公司(Cerebras Systems)。简单地说,Cerebras大胆的做法是建造有史以来最大的芯片。该公司最近估值17亿美元,已从包括Benchmark和红杉(Sequoia)在内的顶级投资者那里筹集了2亿美元。

Cerebras芯片的规格令人难以置信。它大约比一个典型的微处理器大60倍。它是历史上第一个容纳超过1万亿个晶体管(准确地说是1.2万亿)的芯片。它有18 GB的片内内存-同样是有史以来最多的。

将所有计算能力打包到单个硅衬底上提供了诱人的好处:数据移动效率大大提高,内存与处理共存,大规模并行化。但是,轻描淡写地说,工程上的挑战是可笑的。几十年来,制造晶片规模的芯片一直是半导体行业的圣杯,梦寐以求,但从未实现过。

Cerebras首席执行官安德鲁·费尔德曼(Andrew Feldman)说:“每条规则、每一件工具和每一台制造设备都是为普通大小的巧克力片饼干设计的,我们提供了整个饼干纸大小的东西。”“在这条路上的每一步,我们都必须有所创新。”

Cerebras的人工智能芯片已经投入商业使用:就在上周,Argonne国家实验室宣布正在使用Cerebras的芯片来帮助对抗冠状病毒。

另一家采用全新芯片设计方法的初创公司是总部位于旧金山湾区的Groq。与大脑不同,格罗克的芯片专注于推理,而不是模型训练。创始团队拥有世界级的领域专业知识:格罗克的团队包括谷歌TPU项目十名原始成员中的八名,这是首批也是迄今为止最成功的人工智能芯片项目之一。

Groq颠覆了业界的传统智慧,正在建造一种批量为1的芯片,这意味着它一次处理一个数据样本。根据该公司的说法,这种架构可以实现几乎即时的推理(对于自动驾驶汽车等时间敏感型应用至关重要),同时不需要牺牲性能。Groq的芯片在很大程度上是软件定义的,使其具有独特的灵活性和面向未来的能力。

该公司最近宣布,其芯片实现了每秒1千万亿次运算的速度。如果是真的,这将使其成为历史上速度最快的单芯片。

也许没有一家公司比LightMatter拥有更令人费解的技术愿景。由光子学专家创立的波士顿LightMatter正在寻求制造一种人工智能微处理器,而不是由电信号供电,而是由光束供电。该公司已从GV、星火资本(Spark Capital)和Matrix Partners筹集了3300万美元,以实现这一愿景。根据该公司的说法,光的独特属性将使其芯片的性能超过现有解决方案的十分之一。

在这一类别中,还有许多其他玩家值得关注。地平线机器人(Horizon Robotics)和Cambricon Technologies这两家总部位于中国的公司,各自以高于任何其他竞争对手的估值筹集了更多资金。帕洛阿尔托的SambaNova系统公司资金充足,血统深厚。虽然关于SambaNova计划的细节仍然很少,但它的技术似乎特别适合自然语言处理。其他值得注意的初创公司包括Graphcore、Wave Computing、Blaize、神话和Kneron。

几家科技巨头已经启动了自己的内部努力,以开发专门制造的人工智能芯片。这些程序中最成熟的是谷歌的张量处理单元(TPU),如上所述。像往常一样,谷歌领先于技术曲线,于2015年开始开发TPU。最近,亚马逊宣布在2019年12月大张旗鼓地推出InferentiaAI芯片。特斯拉(Tesla)、Facebook和阿里巴巴等科技巨头都有自己的人工智能芯片程序。

开发将为即将到来的人工智能时代提供动力的硬件的竞赛正在进行。如今,半导体行业正在进行的创新比硅谷诞生之初以来的任何时候都要多。数不清的数十亿美元正在发挥作用。

这一下一代芯片将塑造未来几年人工智能领域的轮廓和轨迹。用严乐村(Yann LeCun)的话说:“硬件能力……激励和限制人工智能研究人员会想象并允许自己追求的想法类型。我们可以使用的工具比我们愿意承认的更能左右我们的思想。“