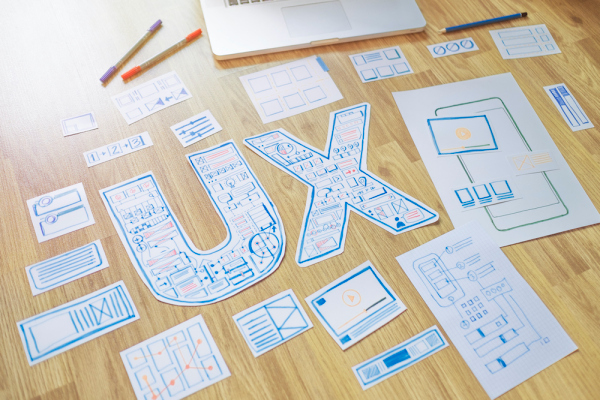

将UX镜头带到你的人工智能项目中的五种方法

黛比·波普(她/她)是特雷弗项目(Trevor Project)的高级产品经理,该项目是世界上最大的针对LGBTQ青少年的自杀预防和危机干预组织。作为2019年谷歌AI Impact Grantee的一个项目,该项目正在建立一个人工智能系统,以识别和优先处理高风险联系人,同时支持更多的年轻人。

应用人工智能的一个先驱是数据-大量的数据!训练AI模型通常需要大数据集,任何拥有大数据集的组织无疑都将面临AI可以帮助解决的挑战。或者,如果数据集还不存在,数据收集可能是人工智能产品开发的“第一阶段”。

无论您计划使用什么数据集,都很可能有人参与了数据的捕获,或者将以某种方式使用您的人工智能功能。UX设计和数据可视化的原则应该在数据捕获和/或向用户呈现数据时及早考虑。

在模型开发开始时了解用户将如何使用您的AI产品,有助于为您的AI项目设置有用的护栏,并确保团队专注于共同的最终目标。

例如,如果我们以电影流媒体服务的“推荐给您”部分为例,在开始数据分析之前概述用户将在此功能中看到的内容,将允许团队只关注将增加价值的模型输出。因此,如果您的用户研究确定电影标题、图像、演员和长度将是用户在推荐中看到的有价值的信息,则工程团队在决定哪些数据集应该训练模型时将具有重要的上下文。演员和电影长度数据似乎是确保推荐准确无误的关键。

之前-用户试图实现的目标是什么?用户是如何获得这种体验的呢?他们要去哪里?他们应该期待什么呢?

在-他们应该看到什么来定位自己?下一步做什么清楚了吗?如何引导他们克服错误?

之后-用户是否实现了他们的目标?这段经历有没有明确的“结局”?后续步骤(如果有)是什么?

了解用户在与模型交互之前、期间和之后应该看到的内容,将确保工程团队从一开始就对AI模型进行准确的数据培训,并提供对用户最有用的输出。

您的用户会知道您从他们那里收集的数据发生了什么变化吗?您为什么需要这些数据?您的用户是否需要阅读您的T&;C页面才能获得提示?考虑将基本原理添加到产品本身中。一句简单的“这些数据将允许我们推荐更好的内容”就可以消除用户体验中的摩擦点,并为体验增加一层透明度。

当用户向Trevor项目的顾问寻求支持时,我们明确表示,我们在与顾问联系之前要求的信息将用于为他们提供更好的支持。

如果您的模型将输出呈现给用户,请更进一步并解释您的模型是如何得出结论的。谷歌的“为什么要做这个广告?”选项可以让您深入了解是什么驱动了您看到的搜索结果。它还允许您完全禁用广告个性化,允许用户控制其个人信息的使用方式。解释您的模型如何工作或其准确性水平可以增加对您的用户群的信任,并使用户能够根据自己的条件决定是否参与到结果中来。低精度水平还可以作为提示,从用户那里收集更多见解,以改进您的模型。

提示用户反馈他们的体验可以让产品团队随着时间的推移不断改进用户体验。在考虑反馈收集时,也要考虑人工智能工程团队如何从持续的用户反馈中获益。有时,人类可以发现人工智能不会发现的明显错误,而您的用户群完全由人类组成!

一个实际收集用户反馈的例子是,当Google识别出一封电子邮件是危险的,但允许用户使用自己的逻辑将该电子邮件标记为“安全”时。这种持续的手动用户校正使模型能够不断了解随着时间的推移,危险的消息传递是什么样子。

如果您的用户群也有上下文知识来解释为什么人工智能是不正确的,那么这个上下文对于改进模型可能是至关重要的。如果用户注意到AI返回的结果中存在异常,请考虑如何包含一种让用户轻松报告异常的方法。您可以问用户什么问题来为工程团队获取关键见解,并提供有用的信号来改进模型?工程团队和UX设计人员可以在模型开发期间一起工作,以便在早期计划反馈收集,并为持续的迭代改进设置模型。

可访问性问题会导致不对称的数据收集,而在排他性数据集上训练的人工智能可能会造成人工智能偏见。例如,在主要由白人男性面孔组成的数据集上训练的面部识别算法,对于任何不是白人或男性的人来说都会表现不佳。对于像特雷弗项目这样直接支持LGBTQ青少年的组织来说,包括性取向和性别认同的考虑是极其重要的。在外部寻找包容性数据集与确保您带到表中或打算收集的数据具有包容性一样重要。

在收集用户数据时,请考虑您的用户将利用哪个平台与您的AI交互,以及如何使其更易于访问。如果你的平台需要付费,不符合可访问性准则,或者用户体验特别繁琐,你从那些负担不起订阅费用、有可访问性需求或不太精通技术的人那里收到的信号会更少。

每个产品领导者和人工智能工程师都有能力确保社会上被边缘化和代表性不足的群体可以访问他们正在开发的产品。了解你在不知不觉中将谁排除在你的数据集中是构建更具包容性的AI产品的第一步。

公平与确保培训数据的包容性齐头并进。测量模型中的公平性要求您了解模型在某些用例中可能不太公平。对于使用人员数据的模型,查看模型在不同人群中的表现可能是一个很好的开端。但是,如果您的数据集不包括人口统计信息,这种类型的公平性分析可能是不可能的。

在设计您的模型时,请考虑数据会如何影响输出,或者它会如何对某些人造成服务不足。确保你用来训练的数据集,以及你从用户那里收集的数据足够丰富,足以衡量公平性。考虑如何监控公平性,将其作为定期模型维护的一部分。设置公平阈值,并创建一个计划,说明如果模型随着时间的推移变得不公平,您将如何调整或重新训练模型。

作为一名开发人工智能工具的新手或经验丰富的技术工作者,考虑您的工具如何被您的用户感知并对其产生影响永远不会太早或太晚。人工智能技术具有规模化接触数百万用户的潜力,可以应用于高风险的用例中。从整体上考虑用户体验-包括人工智能输出将如何影响人们-不仅是最佳实践,而且可能是道德上的必要。