NVIDIA推出恩惠:高性能ARM CPU,用于大AI系统

揭开了NVIDIA的另一个繁忙的春季GPU技术会议,今天早上的图形和加速器设计师正在宣布他们将再次设计自己的基于ARM的CPU。被称为Grace - 在Grace Hopper之后,计算机编程先锋和美国海军后海军上将 - CPU是NVIDIA通过能够提供高性能CPU与其常规GPU商品一起提供高性能CPU的最新刺激。根据NVIDIA的说法,该芯片专为大规模神经网络工作负载而设计,预计将在2023年的NVIDIA产品中获得。

随着两年的时间去筹码准备就绪,NVIDIA目前正在比较伴随着相对的宾馆。该公司仅提供了芯片的有限细节 - 它将基于未来的ARM的新古董核心迭代 - 例如,随着今天的公告有点专注于NVIDIA的未来工作流模型,而不是速度和饲料。如果没有别的,该公司将尽早清楚,至少目前,Grace是NVIDIA的内部产品,作为其较大服务器产品的一部分提供。该公司并不直接为英特尔Xeon或AMD EPYC服务器市场推出,而是建立自己的芯片以补充他们的GPU产品,可以创建一个专业芯片,可以直接连接到他们的GPU并帮助处理巨大的亿万的参数ai楷模。

更广泛地说,Grace旨在填充NVIDIA的AI服务器产品中的CPU大小孔。该公司的GPU非常适合某些类别的深度学习工作负载,但并非所有工作负载都是纯粹的GPU限制,如果只需要CPU来保持GPU喂养。 NVIDIA的当前服务器产品又依赖于AMD的EPYC处理器,这非常快速地用于一般计算目的,但缺乏NVIDIA正在寻找的高速I / O和深度学习优化。特别是,NVIDIA目前是通过使用PCI Express进行CPU-GPU连接的瓶颈瓶颈;他们的GPU可以通过NVLINK在自己的状态中快速交谈,但不会返回主CPU或系统RAM。

解决问题的解决方案,即使在恩典之前也是如此,是使用NVLink进行CPU-GPU通信。以前的NVIDIA已经与OpenPower Foundation合作,以获得NVLink进入Power9的原因,但是这种关系似乎正在出路,既是电力的普及游程和电力10正在跳过NVLink。相反,NVIDIA通过使用必要的NVLink功能构建ARM服务器CPU来完成自己的方式。

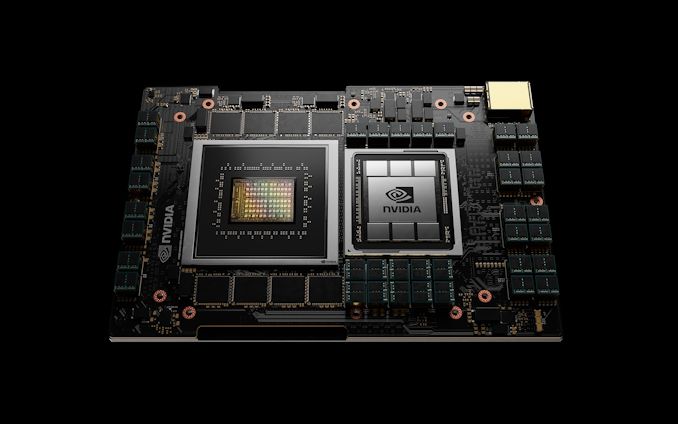

根据NVIDIA的说法,最终结果将是一个高性能和高带宽的CPU,旨在与未来生成NVIDIA服务器GPU的串联工作。与nvidia谈论每个nvidia gpu与一个板上的恩典cpu配对 - 类似于今天的夹层卡 - 不仅CPU性能和系统内存与GPU的数量相比,但是以环形交叉路口方式,恩典将作为一个对NVIDIA的GPU的各种处理器。这是,如果没有别的,是一个非常nvidia解决问题的解决方案,不仅提高了他们的性能,还要给他们一个柜台,应该更传统上集成的AMD或英特尔尝试某种类似的CPU + GPU融合播放。

到2023年,NVIDIA将达到NVLINK 4,其将在CPU和GPU之间提供至少900GB / SEC,而GRACE CPU之间的300GB /秒超过600GB /秒。批判性地,这大于CPU的内存带宽,这意味着NVIDIA的GPU将与CPU的高速缓存相干链路,可以在满带宽下访问系统存储器,并且还允许整个系统具有单个共享存储器地址空间。 NVIDIA描述了这一点是平衡系统中可用的带宽量,而且它们没有错误,但它有更多。拥有一个包装CPU是增加内存数量的MVIDIA的GPU可以有效访问和使用的主要手段,因为内存容量仍然是大型神经网络的主要约束因素 - 您只能有效地将网络与您一样大的网络本地内存池。

并且这种记忆的策略也反映在恩典的内存池设计中。由于NVIDIA将CPU与GPU的共享包装,因此它们将使RAM放在旁边。恩惠配备的GPU模块将包括待定量的LPDDR5x内存量,NVIDIA定位至少500GB /秒的内存带宽。除了在2023年可能成为最高带宽非图形存储器选项外,NVIDIA还将LPDDR5x推出使用LPDDR5X作为能源效率的增益,由于该技术的重点束缚根和非常短的痕量长度。而且,由于这是服务器部分,因此Grace的内存将成为ECC启用。

至于CPU性能,这实际上是NVIDIA最少的部分。该公司将使用未来一代ARM的新夜CPU核心,其中初始N1设计已经转动头部。但除此之外,所有公司都说的是,核心应该在SpectRate2017_int_Base吞吐量基准上打破300点,这将与AMD的第二代64核心ePYC CPU相媲美。该公司还没有说如何配置CPU或正在专门为神经网络处理添加哪些优化。但由于恩典旨在支持NVIDIA的GPU,我希望它能够更强大,因为GPU一般较弱。

否则,如前所述,NVIDIA的恩典氛围的目标大大减少了最大神经网络模型所需的时间。 NVIDIA在1万亿参数型号上进行10倍的性能,以及64个模块Grace + A100系统的性能预测(具有理论NVLink 4支持)将是从一个月到三天的培训。或者,能够在8个模块系统上对5000亿参数模型进行实时推断。

总的来说,这是NVIDIA在数据中心CPU市场的第二个真实刺激 - 第一个可能成功的第一个。 NVIDIA的项目丹佛最初在十年前宣布,从未真正被淘汰,因为NVIDIA预期。自定义武器核心的家庭从来没有足够的好处,从来没有用NVIDIA的移动SOC。相比之下,Grace是NVIDIA的一个更安全的项目;他们只是许可手臂核心而不是自己建造自己的核心,而那些核心也将被许多其他各方使用。因此,NVIDIA的风险降低到很大程度上让I / O和内存管道右侧,并保持最终设计能源效率。

如果所有人都根据计划进行,期待在2023年看到恩典.Nvidia已经证实,恩典模块可用于HGX载波,并通过扩展DGX和所有使用这些板的其他系统。因此,虽然我们没有看到NVIDIA的全部恩典计划,但很明显他们计划使其成为未来服务器产品的核心部分。

即使恩典不是发货,直到2023年,NVIDIA已经排队了他们的第一个客户的硬件 - 它们是超级计算机客户,不少。瑞士国家超级计算中心(CSCS)和洛斯阿拉莫斯国家实验室都宣布他们今天将根据恩典订购超级计算机。两个系统都将由HPE的CRAY组构建,并在2023年设置上网。

CSCS的系统称为阿尔卑斯山,将更换当前的Piz Daint系统,Xeon Plus Nvidia P100集群。根据两家公司,阿尔卑斯al将提供20个AI性能的EXAFLOPS,这可能是CPU,CUDA核心和张量核心吞吐量的组合。当它推出时,阿尔卑斯al应该是世界上最快的互联的超级计算机。

然而,有趣的是,CSCS对系统的抱负超出了机器学习工作负载。该研究所表示,他们将使用ALPS作为通用系统,致力于更传统的HPC型任务以及以AI为中心的任务。这包括CSCS对天气和气候的传统研究,也可以使用预先使用的天气和气候。

如前所述,阿尔卑斯al将由HPE构建,他将在其先前宣布的CRAY EX架构上基于其基础。这将使NVIDIA的恩典成为CRAY EX的第二个CPU选项以及AMD的EPYC处理器。

与此同时,LOS Alamos的系统正在开发作为实验室和NVIDIA之间正在进行的协作的一部分,其中LANL设置为将获得宽限系统的第一个基于美国的客户。 LANL并没有讨论其系统的预期绩效,超出了它预计它是“领导类别”的事实,尽管实验室正在计划用于3D仿真,但利用宽限性提供的最大数据集规模。 LANL系统设置为在2023年初交付。

发表评论我认为每个人都看到这个即将到来的 - nvidia'曾一直雇用一堆以服务器为中心的设计工程师,并且与IBM(Power10没有NVLINK)的明显分手相当强烈地指向NVIDIA服务器处理器。那么核心将是什么' n2,还是未来的新v系列?如果它'在2023年初将在系统中,它已经很远在发展中。回复