从统计学走向悲伤的最后阶段--机器学习

在过去的几个月里,我一直在准备和申请数据科学的工作。数据科学界可能会拒绝我,因为我既没有经验,也没有学士学位以上的文凭,在这种情况下,我会做其他的事情。不管我的未来是什么,我想我已经很好地掌握了机器学习背后的心态,以及它与传统统计学的不同之处,所以我想我应该写给那些和我有相似背景的人,他们正在考虑采取类似的行动。1个。

这篇文章的目标读者是那些精通统计学,但不能真正“理解”机器学习的人,他们想要在大约15分钟的阅读时间里理解机器学习的要旨。如果你有传统的学术统计背景(无论是计量经济学、生物统计学、心理测量学等),有两个很好的理由去学习更多关于数据科学的知识:

首先,数据科学工作的薪酬往往高于其他量化工作。提起这件事有点禁忌--毕竟,我们不都应该出于激情和爱这样做吗?我不会假装赚更多的钱是追求某件事的坏理由,我也不会对那些主要动机是赚更多钱的人保留任何判断。

其次,数据科学家真的做了一些非常有趣的事情,并且有一种非常有趣的方法来处理数据,即使我的直觉反应是,当有人说“教授模型”而不是“估计参数”时,我会呕吐。

在许多方面,数据科学的世界都隐藏在人们的视线之外,而不是更具学术头脑的定量学科。我不会花太多时间讨论数据科学家使用的不同算法:部分原因是他们使用的许多算法与统计学家使用的算法相同,但也因为算法不是本文的重点。在这篇文章中,我将写一篇简短的指南,教你如何快速地将你的统计技能转化为数据科学。

看完这篇文章后,我推荐下载(免费)并通读统计学习要素(这里是TESL)。这是一本优秀而全面的教科书,涵盖了所有主要的机器学习主题,面向具有很强数学背景的人,特别是线性代数。

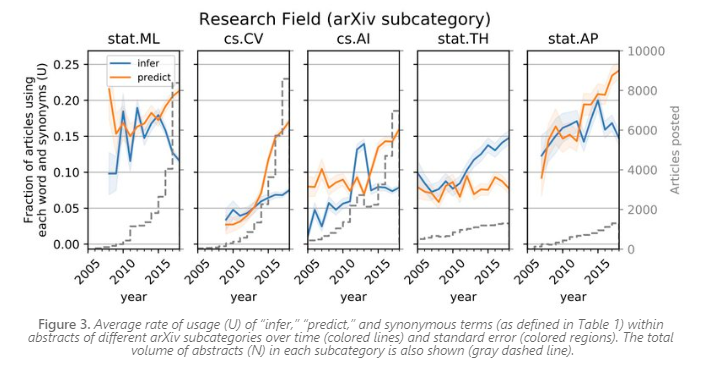

机器学习和统计学之间的主要区别是我称之为“β-HAT与Y-HAT”。(我还听到有人把它描述为推论与预测。)。基本上,学术界非常关心估计的参数是什么样子(β-HAT),而机器学习更关心的是能够在给定一些输入的情况下估计因变量(Y-HAT)。还有其他几个不同之处,但它们都植根于此。一旦你理解了这一点,结合你的统计背景,你就会基本理解机器学习。

我的约会对象:我在学习机器学习我(试图给她留下深刻印象):我也在加州学习如何做回归

-高级OLS工程师(@ryxcommar)2019年6月29日。

一旦您不再关心您的参数,您就可以开始让它们看起来像是无稽之谈,也就是说,通过添加偏差(参数是错误的)或不一致(参数在无限的观察中不收敛)。在某些情况下,您甚至可以将模型或多或少变成一个完全的黑匣子,只是吐出一个y-hat;基本上这就是神经网络。传统上,使用这样的参数在学术界是一大罪过,因为你不能说出任何关于参数的有趣的事情,但机器学习的诀窍是,你不需要说任何关于参数的事情。在机器学习中,您的重点是描述y-HAT,而不是β-HAT。

为什么这么爱你的帽子?友好的、不那么愤世嫉俗的回答是,在过去的十年里,每个人都得到了大量的数据和计算能力,他们想用这些数据和计算能力做一些酷而有用的事情。机器学习是一种非常自然的方式来利用所有这些数据和能力,因为机器学习有工具来处理多重共线性,并在数据中发现真正深刻的、隐藏的相关性和模式。正如您可以想象的那样,机器学习不会让您回避指定数据和模型的肮脏工作(也就是。“功能工程,”根据数据科学家的说法),但它使运行程序变得容易得多,而不用太费力地考虑如何设置它。在统计学上,不好的结果可能是错误的,因为不好的原因而正确是不可接受的。在机器学习中,如果他们灾难性地无法预测未来,那么糟糕的结果就是错误的,而且没有人太关心你的水晶球是如何工作的,他们只关心它是否工作。

对Y-HAT的这种新发现有点投机取巧,但公平地说,对于广泛的业务用例而言,Y-HAT往往比β-HAT更重要。例如:

推荐系统(比如YouTube向你展示更多你可能喜欢的视频,或者向客户展示他们下一步可能想要购买的商品)。

预测(如估计顾客将在商店购买多少,或某人拖欠贷款的可能性有多大)。

所有这些任务都不需要人来解释参数,找出是什么推动了什么,才能得到一个充分可接受的答案;这些都是预测性的。

在我掌握如何从y-hat的角度思考之前,数据科学家所做的很多事情对我来说几乎没有意义。

我在2017年第一次遇到它时,有一个大问题对我来说毫无意义,那就是数据科学家将他们的数据分成了“训练数据”、“验证数据”和“测试数据”。这对戴β帽子的人来说没有意义的原因是,增加更多的观测应该会让你更接近真正的参数,因为,你知道,大数定律。老派的思维过程有两个问题。第一个问题是,如果故意允许您的参数稍有偏差,则没有“true”参数。第二,如果你的参数被允许渐近不一致,就不能保证收敛到任何东西。

我相信您会问:“为什么要允许您的参数有偏见呢?”问得好。最直截了当的答案是,存在偏差和方差之间的权衡。维基百科的文章对此进行了很好的说明和解释。就β-Hat的目的而言,允许任何偏见的想法都是疯狂的。对于y-hat而言,添加一点偏差以换取方差的大幅降低可以提高模型的预测能力。

岭回归是添加偏差的最直接的例子。如果你理解了OLS,你就像是在阅读两段话,就不能理解岭回归了。

基本上,不是像处理OLS那样仅仅求解最小化残差平方和的β矢量,也就是说,您还可以在试图找到最小化目标函数的β-HAT时向大平方β增加“惩罚”。所以你把它加到目标函数上,其中λ是某个常量。然后,最后但并非最不重要的是,您对每列进行“标准化”,这意味着通过将每列减去该列的平均值,再除以该列的标准差,将其转换为:(这样做的目的是使参数衡量对整体结果的相对影响,而不是名义影响,否则惩罚将不会以您希望的方式进行)。这就给出了岭回归估计器:

当λ=0时,您刚才附加到目标函数上的平方β的总和等于0,而不管β-HAT向量是什么,所以您只需要再次得到OLS。作为λ→∞,对所有非零HAT的惩罚变得如此巨大,以至于惩罚不会超过目标函数的唯一方法是使所有参数β-β=0。事实证明,目标函数的闭合形式解与OLS的闭合形式解非常相似:

一切都很简单,但真正的问题是你为什么要这么做?如果您不关心参数的可解释性/偏倚,但是您希望模型比常规OL更好地预测样本外,您可以通过交叉验证找到一些λ的值,它比λ=0更适合,也就是使预测误差最小化。但是为了交叉验证数据,您需要将数据拆分成用于估计参数(训练数据)的数据和用于对(验证数据)执行交叉验证的数据。这个过程就是设置您的λ的过程。

岭回归是L2正则化的OLS,是参数的平方惩罚。L1正则化采用参数的绝对值作为惩罚,而不是平方(即套索)。当然,L1和L2正则化可以用于线性回归之外的环境中,例如Logistic回归。这些正则化方法特别擅长处理多重共线性,这肯定是您在处理数千列公司数据时遇到的问题,并且没有令人信服的方法来决定使用哪一列是最好的。2个。

我可以继续讲下去,但我写这篇博客的原因并不是把所有的TESL都吐出来。我喜欢展示岭回归作为机器学习的一个例子,因为它非常类似于OLS,但完全和毫不掩饰地进行了修改,以用于预测目的,而不是推理目的。β-HAT从来不是岭回归的重点;它都是关于Y-HAT的。

让我们举几个例子来说明你在做生意时可能会遇到的一些问题,以及有统计和/或机器学习背景的人可能会如何处理这些问题。我正在避免那些显而易见的东西,比如推荐系统来推荐更细微的东西。

比方说,你的实体零售公司想要设计优惠券小册子,你可以邮寄给下一季。因为你只有这么多的平面设计师,所以你只能制作几十种优惠券小册子的变体。你的目标是你想要这些优惠券最大化利润。

这是Y-HAT问题,还是β-HAT问题?嗯,两者都有。

Y-HAT问题从立体声开始,根据您掌握的所有客户信息对客户进行细分。也许您可以使用k-means聚类来创建7种不同类型的客户。这不仅使为有限大小的平面设计部门创建有限数量的优惠券变得更容易,而且还有助于在提交给高层管理人员的幻灯片上很好地讲述故事,这让他们感到高兴,这反过来又给了他们一个继续支付你6位数工资的理由。

也许你的某个小组是早产儿或准妈妈,你想给他们寄婴儿护理产品的优惠券,但你需要先预测他们是否怀孕。(注意:这可能会给您带来一些麻烦。)。

传统的统计问题来自于确定发送优惠券是否会让他们购买更多。你可能有很多方法来解决这个问题,但无论如何,它要么归结为随机对照试验,要么就是用自然实验来估计参数。如果你不得不忍住不寄一大堆期待妈妈的优惠券,那么前一种设计是不可取的,因为这可能会损失宝贵的客户群的销售额。在后一种设计中,您必须想出一种方法来估计参数,该参数衡量如果客户收到或没有收到优惠券小册子,他们的行为会有多大程度的不同。你可能还想看看因果关系是如何根据事情的不同而变化的,比如你是否确定自己正确地将她们归类为准妈妈。

我不确定有多少企业会认为这是一个纯粹的机器学习问题,但事实并非如此。优惠券小册子不是你预测顾客下一步会买的东西的清单,而是你认为可以通过价格歧视有利可图地诱使人们购买的东西的清单,也就是说,这是一个推断问题。

所以,请记住,当你在广告公司面试“数据科学家”的角色时,因果推断是这份工作的重要组成部分。广告商想知道他们的广告是否引起了人们的购买。选择偏见是一种巨大的浪费。同样,使用优惠券本身并不意味着你赢得了一个新客户(他们可能已经在没有优惠券的情况下购买了),广告商在衡量他们的广告产生的收入时也面临着同样的问题--也就是说,这些人无论如何都会购买产品吗?

比方说,你在大型公司的一个部门工作,该部门管理着帮助浏览简历以找到“最佳”应聘者的软件。以前员工的简历被用来训练评估新候选人简历的模型。

这是Y-HAT问题,还是β-HAT问题?刁钻的问题!要么是,要么都不是,要不就是两者兼而有之。无论你做什么,最重要的一点是:记住,天真的y-hat方法会导致很多GIGO问题,甚至可能违反联邦法律。

这不是我是假想的,也不是什么危言耸听的社会正义斗士--这真的发生在亚马逊。他们的机器学习算法用来找出哪些简历上有全明星候选人,结果却是歧视女性,因为他们的培训数据利用了他们之前的招聘做法,这是对女性的歧视。完全清楚的是,这绝对与女性的能力无关,而完全与从糟糕的数据推断的愚蠢行为有关。垃圾进来,垃圾出来。

这就是为什么拼接板的创建者Maciej Ceglowski将机器学习称为“为了偏见而洗钱”的原因。因为深度学习算法中的参数是人类无法解释或指导的,而每个新申请者的唯一输入是他们的简历,所以该算法看起来应该对天真的观察者没有偏见,但事实并非如此。

尽管如此,仍然保持y-hat方法的受保护类别的歧视问题有很多解决方法,例如预处理训练数据,添加参数以抵消歧视性做法,删除所有歧视性参数,或者在事后调整模型以使其相等。

这里提到的担忧并不局限于招聘实践;它们还延伸到其他联邦法律,如“公平信用报告法”和“公平住房法”。即使不考虑歧视性做法,有时你的深度学习模式只会产生明显愚蠢、过度匹配的结果,而你并不知道这些结果,因为它是一个完全的黑匣子:

一项对简历筛选算法的审查发现,最能反映工作表现的两个因素是名为贾里德和玩高中曲棍球的https://t.co/dCJQV3LKR6 pic.twitter.com/2oZHYVAWSb。

-瑞秋·托马斯(@MATH_RACHER)2019年5月25日

最大的问题似乎是,如果神经网络方法在招聘/招聘方面完全脱轨,它不会立即给出用户反馈。可能要花几年时间才能弄清楚你根据算法雇佣的所有员工是否都是笨蛋。要真正理解这一点,请考虑一种相反的情况,在这种情况下,用户反馈非常清晰和容易衡量:OpenAI,这是一个玩DOTA 2(一款竞争性视频游戏)的系统。如果它在与职业球员的比赛中获胜,它就会奏效;如果它输了,它就不会奏效。此外,OpenAI并不是针对已经存在偏见的数据进行训练的,它是针对自己进行训练的。

尽管问题在本质上具有很强的预测性,但也许β-HAT方法并不是那么糟糕。

机器学习真的被夸大了。经常是统计数据伪装成更宏伟的东西。它最热心的支持者是令人难以置信的恼人的、容易被憎恨的技术人员。

我不是想贬低寻找相关性的行为;毕竟,“相关性不是因果关系,但它肯定是一种暗示。”我们新发现的找到比以往任何时候都更多的关联的能力是非常有用的,特别是在生命科学领域。但是,我们有多少次只是寻找相关性,因为另一种选择,即寻找因果关系,是很难的,而我们只是懒惰呢?我们做花哨的神经网络东西是为了给别人留下深刻印象,感觉自己很聪明,而不是为了阐明重要的现象,这有时需要枯燥乏味,使用OLS和一些老式的东西?

如果下一代科学家不认真对待因果推理,我们有理由担心他们。如果你是一名传统的统计学家,你也有理由抱怨自己被排除在淘金热之外。一个薪水只有5位数、对预测模型持保留怀疑态度的卑微统计学家能做什么呢?

我认为你能做的最好的事情就是接受它。统计学家给数据科学界带来了很多东西,引用一位自00年代中期以来一直从事人工智能研究的朋友的话说,“事实证明,具有统计背景的人是相当优秀的数据科学家。”有时候,在招聘过程中,感觉雇主认为专注于计算机科学几年的人可以比做了几年统计的人更好地做数据科学。当然,这有点不公平。如果亚马逊的数据科学部门雇佣更多有统计背景的人,而他们不会浪费数年时间试图用黑匣子算法实现招聘自动化,那么这种可能性有多大?

当我说数据科学家需要知道统计学时,我并不是说他们需要知道卡塞拉和伯杰的所有渐近定理,我的意思是,他们需要知道为什么拥有p>;n意味着你不能进行线性回归。https://t.co/UFP5gKT5mS。

-Ph.Demetri(@PhDemetri)2019年7月7日

将机器学习描述为“加州的回归”显然是对数据科学家和硅谷技术人员的贬低,但这也是对熟悉回归的统计学家的行动呼吁。在旧金山,每个27岁的留着胡子的家伙只要拥有一件粉红色的马球衫,就能比你多赚数万美元,因为你把他们的回归称为“机器学习”。是的,系统被操纵了,但是你打算怎么做呢?你可以拿你的老生常谈的统计数字发脾气。或者你可以开始阅读TESL,试着从易受影响的风险资本家那里获得一些甜蜜的、甜蜜的机器学习面团,他们把钱像糖果一样分发给任何会输入几行代码的人。

就这篇博客文章而言,机器学习指的是使用(通常是大型)数据集来识别模式和相关性的计算机算法,通常用于预测目的。数据科学指的是机器学习、编码和更传统的统计学的结合。

没有机器学习知识的经济学家和政治学家可能非常熟悉主成分分析,这是处理多重共线性和利用大量列的另一种方式,但代价是一定程度的可解释性。在TESL的第三章中,主成分回归与岭回归和套索回归并驾齐驱。