在AI损失压缩问题中为道德的斗争

在2020年夏天,我偶然发现了最卓越的推特交流。 Yann Lecun是最负责现代AI和机器学习(ML)的数字之一,由Google *名为Timnit Gebru的研究员暂时追赶Twitter,他们似乎是领导经典的社交媒体堆积反对他。

Gebru是AI伦理的年轻领域的领导者。当我开始关注时发现了什么;道德人,"由于他们在AI / ml中的不结盟的同事经常指他们,是Gebru'与Lecun的Twitter Spat是一个持续辩论的一个例子,她和她的盟友继续与AI / ML世界上的其他人一起。

这场辩论在机器学习模型 - 种族,班级和性别偏见方面偏见,主要是 - 应该找到这种偏见的责任。

很大程度上致力于揭开甘肃和她的盟友的工作,现在每个人都同意,许多模型数据科学和机器学习(ml)字段向世界发出危险的偏见。所以战斗是解决问题的根源。

并通过“问题来源,”我不仅仅是意思是“在这种复杂的技术设备的管道中的那里就是偏见,”虽然这是其中的一部分。但甚至更大的部分是关于哪些部门对危险责任的人。

分裂的轮廓,至少在他们在Twitter上表现出来,往往归结为:

是培训数据的偏见,用于教育这些复杂的软件关于世界的软件吗?因为如果是这样,那么故障就在于培训模型并为最终用户部署它们的工程师。他们需要更多地照顾组装他们的训练数据集。

或者,我们看的偏见是我们看的,包括在模特的设计中自己?在这种情况下,其中部分问题起源于覆盖谷歌和Facebook等公司的楼宇的数学书呆子的白板上的一路返回。那些家伙需要......好吧,答案主要似乎是他们需要更少的白人。

Lecun在新的图像综合模型中存在偏见的训练数据(更稍后的模型)。在臭名昭着的Twitter Exchange中,Lecun坚持认为,在这个特殊的例子中,显示屏上的明显的防黑色种族偏见有一个直接的修复:只需在模型的训练数据中包含更多黑色面孔。

如果图像合成算法在非洲数据集上培训,Lecun认为,它会在非白人面前比在北欧数据集上训练的非凡面孔做得更好。

这种直觉的声音断言迅速向轨道发送了Gebru进入轨道,她点亮了Lecun,因为没有熟悉一项工作的工作组,据说是Ml种族偏见从训练数据远远超过培训数据,并且确实甚至是模特本身有偏见。

在AI中修复种族偏见不仅仅是用更多的黑色素(例如)注入培训数据的问题,AI伦理人群辩称 - 实际模型正在被白色家伙开发,他们的岛屿,白色的优先级以某种方式在算法中偏见,用于训练数据。

这种断言(白人设计的)模型本质上偏见,并且仍然没有简单的修复,涉及调整培训数据,是AI道德人的核心索赔之一。它一次又一次地出现了。

例如,这里,谷歌脑' S Sarah Hooker试图在Twitter上制作典型的模型案例:

我很高兴地用妓女找到这个线程。在所有的时间我和他们看着这个问题的模型偏见,它的伦理案似乎完全由一些简单的真相动力,但以密集,尖刺的理论,数学层装甲社会正义术语,所以道德人们可以像一些后期战争马车一样骑行,射击AK进入空气并送柔软,惊人的ML极客争先恐后地争抢。

所以我担心我一直错过了一些东西 - 那里有更多的东西,而不是一些重要的,但相当基本的见解,以便在文化战争中试图。但是在进行论文中,事实不如。 (有关妓女线程中的论文的更详细讨论,请参阅附录。)

*注意:我对Gebru&#39的出发主题进行了一些报告,我在Barpod集中覆盖,并在这篇文章中获得了'也许在未来的帖子中,我可以重新返回一些并扩展它,因为辐射仍然在新闻中。

作为我'通过AI伦理材料,我发现,我发现很多蛇吃它的尾巴质量:它经常似乎致力于复杂化相当简单,直观的套装关于简化行为中固有的权力动态的点。

在这里,我的第一次尝试煮到基本的论点,我看到在AI道德工作中一遍又一遍地做成,不同数量的数学,实验和理论:

代表世界地图,照片,录音,金融风险模型,机器学习语言模型等的技术 - 是基本上的选择性和歧视性。这些技术使得植根于价值层次的假设(即,所代表的某些部分比其他部分更重要),并且它们必然会重新强调或省略其建设者和用户不太重要的细节。

一些技术本身自己很简单而且像Mercator投影一样,有些是复杂和新的,如GPT-3,但他们都涉及(重新)呈现一种压缩,简化,值的一件事在世界上,'

由现状的受益者产生的陈述将反映地位 - QUI值,并且倾向于在延长现状中发挥作用。

不喜欢现状的人将自然地对象延期现状的那些象征 - 一个死人,文学佳能,大型,有利可图的ML语言模型等的雕像。

现在,到目前为止,这些见解都不是新的。但是,如果你能找到一个热门的人类努力的新领域,可以将这种东西翻译成,你可以用一个全吹的学科的疏忽,然后你可以让自己一个职业生涯将这些真理扔进玻璃大厅力量。

但让我不要在自己领先地位。毕竟,像AI伦理人群一样,我打算挤奶这个话题为时事通讯饲料,所以我' LL必须自己节奏。

将现实的代表性练习成“相同”和“不同”,然后将那些桶安排成层级,结果是存在,底部不存在,非常类似于底部有什么信息理论家称呼有损压缩。

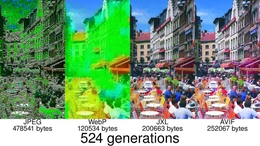

有损压缩与无损压缩不同。前者涉及将一些信息抛出以减少文件的大小,而后者涉及符号的巧妙替代,以便在没有实际信息丢失的情况下减少文件大小。我们使用有损压缩,因为我们生活在一个限制和权衡的世界,其中带宽,存储和能量是有限的,必须配给。

现在,我不一定认为自己是一种有损压缩的形式。相反,我的兴趣指出,两种传统的代表行为和现代损失压缩算法都涉及类似的工作。

但首先,关于术语的另一个快速注意:i'请参阅所代表的对象(例如,画家画家绘画,地理学家正在映射,文件压缩算法开发人员是压缩的)作为范式。我为方便起见而这样做,并且作为柏拉图的一点点点头。 (虽然在后者的尊重中,我基本上将其从柏拉图的概念上倒了,是物质世界中不存在的完美,不变的原型。无论如何,那个' SA故事另一天。)

随着那种方式,这里有一些人造的一些事情,这些事情是由创造一个表示的人,无论是雕塑的雕塑还是压缩图片。

歧视:这个步骤是关于识别你'重新试图保护的信号,与噪音不同。来自噪声的分离信号涉及将范例划分为可以在下一步骤中分配值的质量或功能集中。请注意,命名一个功能的简单行为为"信号"而另一个是"噪音"涉及在范式上施加自己的层次结构。

组织:有损压缩的进一步不仅仅是将信号从噪声分离。它还识别必须保留的信号的高价值部分,以及可能丢失的低值部件。这是您询问的部分,必须反映在代表中的范例的基本部分是什么,以及可以省略哪些部件?还是,更多的层次结构。

评估:如果您'重新创建表示,或创建用于生成表示的算法(例如,某些类型的压缩算法,A或数学模型),您始终通过比较您所识别的功能来评估您的结果原始对象(步骤1)与原始对象中的那些相同功能的表示,检查无论多么保真度,您认为表示应该具有。

理想情况下,这一过程的落下了什么,是世界上有些东西的有用表示。显然,它不是本身的东西(地图不是领土!)但它' SA方便的方式来让我们的有限思想周围自己,并用于沟通这件事,并致力于推理,以及与其他人争论是什么,也许应该是。

创建表示涉及制定反映您的价值观的权衡和选择。范例的某些部分将在代表中提升,而其他部分则会被遗漏。

只要我们使用表示争论世界,就是一个稀缺和限制世界的权力的代表性。

例如,如果您代表下面的页面,则计算和/或存储约束可能强制挑选其中的哪些部分包含忽略。在大多数情况下,如果您被迫在柏拉图的希腊文本和利润率中的评论之间挑选,赔率是边缘效果。

ML类型很清楚感知和表示的基本人工机械是固有的歧视性和分层。例如,这里'在大型图像数据集中的伦理问题的一部分涵盖了我刚刚做得很多的道德问题:

最后,缩小并采取广泛的观点使我们能够看到开始对分类,分类和标记任务开始的实践,赋予分类器的权力来决定什么是合法,正常或正确的方式,表演,在社会世界中表现[10]。对于任何特定的社会,往常被认为是正常或可接受的,通常由主导意识形态决定。分类系统,在电力不对称的社会层次结构内运营,必然嵌入和放大历史和文化偏见,不公正和偏见[97]

本文刚刚发生在我的屏幕上,但如果我一直保留这些文件,我可以乘以示例。

每个人都知道这张地图是什么 - 它是2016年的县级总统选举结果,其中一方获得了最多的票数。这是误导性的,因为在看了它,你不知道团队蓝击队的队伍的全国投票数目两个百分点。但很少有人可以用它来说是一个问题,一种非常具体的有损压缩:量化。

涉及图像处理的量化是通过将值范围压缩到单量子值来实现的有损压缩技术。当给定流中的离散符号的数量减少时,流变得更加可压缩。例如,减少表示数字图像所需的颜色数量使得可以减少其文件大小。

臭名昭着的红色/蓝图实际上是通过量化压缩的图像。县级数据量化为两种颜色之一 - 红色或蓝色。然后,状态级数据进一步向相同的两种颜色量化。每个州都获得了一点信息;整个美国政治景观只在6.25个字节中呈现。

由于其在我们的红色与蓝权力斗争中的作用,这张地图是令人争议的,因为它是一种提升一些声音和沉默他人的方式。因此,它'是主要点I' m试图在这篇文章中进行的卓越示例:从自然范式中提取有限特征的行为,然后代表文化中的那些高价值特征一些类型的产品,总是关于某种级别的电力。

再一次,这一点都没有小说或深。事实上,我和所有这一切都越来越多的古老地面。 (更多关于在后续帖子中的大部分材料的古代。)

在这一点上,我应该简要循环回到精确的技术问题,这促成了Lecun v。玉布尘埃。

左侧是奥巴马的量化图片,损失压缩算法的输出就像产生红色/蓝图的那样。在右边是将名为脉冲的新的沉积算法应用于该量化图像的结果。

脉冲的目标是通过加入损失压缩的信息来扭转量化的影响。在理论上,这可能会产生你在科幻的效果显示,那家伙说“计算机,增强!”而颗粒状图像神奇地清晰。除了在这种情况下,计算机做了一种种族主义。

脉冲如何采用低信息图像并填写在量化过程中丢失的数据中?算法唯一可以填充与奥巴马的特定形象丢失的原始数据的任何东西是可能的,这是它是否已经在奥巴马照片的数据集上培训。然后它可以使用它的内部表示奥巴马的脸部来填补靠近缺失像素的东西。

但脉冲没有那种方式训练。它在被白人面孔主导的数据集上训练,因此随机白人面部数据是它用于填补奥巴马图片中的信息空白。结果是面对真实的黑人总统,变成了一个实际存在的计算机生成的白人的相似之处。

Lecun指出,“白奥巴马”形象肯定是以白色人为中心的训练数据的错。但从那里,他被人们堆积了,坚持不懈,脉冲等算法可以是并且经常是种族偏见的,并且这是一个责备和leecun的道奇,粉笔粉化这些结果达到了单独的数据集。

然而,尽管所有的大喊大叫和名称,但通过实际展示脉冲与其培训数据无关的偏置方式,没有人曾经驳回了Lecun。实际上,引用的偏差型号的少数例子是相同的模式:通过有损压缩抛出的角箱。

换句话说,它们是模型强调数据集的更常见特征的地方的示例,并使较少的共同特征进行了解除。

事实上,在所有的时间,到目前为止,与AI伦理文学迄今为止,我在我看来,Gebru等人称称之为“模型偏见”,除了在表示的部分中上面概述的动力动力学和压缩。

我尚未找到一个不适合这种模式的涉嫌模型偏差的例子。

一直在AI伦理文学中始终强调的另一个点,是在大型,强大,地位的现状,如谷歌等地区,在那里,在那里,在那里,' SA反馈循环:模型被释放回到现实世界,在哪里他们倾向于以某种方式加强,这些现状产生了它们。

这种状态的圆形性quo =>模型=>状态Quo很好地覆盖着Cathy O' Neil' 2016年的2016年,数学毁灭武器。 O' Neill大多关注大型金融所用的模型,但原理是完全相同的 - 模型Don' T只是反映了现状,他们'越来越重要的是延伸它。或者,借唐纳德·麦肯齐的金融模型的甚至早期书籍标题借词,这些模型是"发动机,不是相机。"

除非我错过了一些重要的东西,除非是一个非常大的AI道德工作,否则是陈述和重新陈述和遗憾的真相,这是一个很大,昂贵,公众的社会等级的公众代表性是那个非常等级的强大的妄想者。它' s。这是The The The The The The The The The Cheet ...和论文......和会议......和纪律。

在制定Gebru'纸张,大型语言模型(“大”,因为他们在来自互联网野外的狂野的狂放的文本的大规模,不成熟语法上培训)重新存在,或者"鹦鹉,& #34;有问题的语言现状。在鹦鹉鹦鹉,他们可以延续它。

随着人们在社会的种族主义的特权职位,令人厌恶的,能力等的职位上,往往在LMS的训练数据中倾向于超人,因此,这种培训数据因此包括编码的偏差,许多已经被认为是有害...

在本节中,我们讨论了人类倾向于如何将意义归因于文本,与大型LMS学习人类与各种偏见和其他有害态度相关的形式的能力相结合,导致现实世界危害的风险,应该生成的文本可以传播。 1

作为培训作为历史学家的人,它并不令人惊讶地对我来说,罗马斗兽场的真实 - 从班级分层的座位安排到中央景观的一切 - 也是真正的复杂也是如此和昂贵的公众展示谷歌'语言模型。

要返回到我们的印刷页面隐喻,页面本身是一个层次结构:页面主体中的内容是以中心为中心的,因为出版商认为市场价值是作者的声音,并且利润率中的内容是以居中定期的,因为出版商认为那些边际的声音有较少的价值。此外,主体中的思想和词语的选择和安排反映了自己认为是重要的。

因此,任何包含在其培训数据中的打印页面的人都已经从多级层次结构(通常是状态 - QUO)值和假设开始,反映了哪些作者和想法升高并受到抑制。

那么,AI伦理人群肯定是纠正,偏见在各个层面的各地。他们有权指出,因为页面边缘(或在数据集的长尾处的数据)经常反映更大的社交层次结构,然后具有有损压缩特性(即,大多数)的算法将放大中心和沉默边缘。

但是Lecun也是正确的,这种社会偏见在训练数据中反映出来。此外,Lecun也充分了解AI伦理员正在偏离无处不在的点,但是修复了“到处”不是他的生命的工作;所以,他把它带到了那个生活中的人的下巴。但我们会在这篇文章结束时返回Lecun。

如果您是AI伦理主义,政治项目的政治项目都是关于在页面边缘提升声音的情况下,那么损坏的损坏压缩现实的现实呈现出以下选项:

分离:在仔细建造的乌托邦数据集中培训模型,以代表您对完全公平的世界的非殖民化愿景。 definiti.

......